Beim Realtime Bidding hat man in der Regel die Wahl zwischen mehreren Alternativen, beispielsweise beim Design eines Banners, das dem Nutzer angezeigt werden soll. Hierbei die richtige Entscheidung zu treffen, kann über den Erfolg der ganzen Werbekampagne entscheiden.

Ein bekannter Weg, um sich für eine Option zu entscheiden, ist der A/B Test: Dabei wird jedes Design einer bestimmten Anzahl an Nutzern angezeigt und die Anzahl der positiven Reaktionen gezählt. Das können Klicks, Downloads oder jede andere Aktion seitens des Nutzers sein, anhand derer der Kampagnenerfolg gemessen wird. Das Design, das die meisten Reaktionen hervorruft, gewinnt.

Bei dieser Herangehensweise gibt es allerdings einen Haken: Wenn zehn verschiedene Designs mit jeweils 1.000 Einblendungen getestet werden sollen, steht schon von vornherein fest, dass 9.000 an ungeeignete Designs verschwendet werden. Daher ist es deutlich cleverer, bereits in der Testphase dynamisch zu entscheiden, ob es sich lohnt, noch mehr Geld in ein Banner zu investieren oder ob sich bereits hinreichend gezeigt hat, dass es bei der Zielgruppe nicht funktioniert und somit ausgeschlossen werden kann.

Anders formuliert: Die Erkundungsphase, in welcher das optimale Banner ermittelt wird, sollte so kurz wie möglich sein, um so schnell wie möglich von den Ergebnissen profitieren zu können.

Schnelle Bandit Algorithmen

Algorithmen, die eine derartige dynamische Komponente bieten, bezeichnet man als Bandit-Algorithmen. Der Name stammt von einem anderen Anwendungsfall dieser Algorithmen: Ein Spieler in einem Casino fordert sein Glück am „einarmigen Banditen“ heraus, einem Spielautomaten, der dadurch betätigt wird, indem der Hebel oder auch ‚Arm’, der sich an der Seite des Automaten befindet, nach unten gedrückt wird.

Jeder dieser Automaten hat seine individuelle Gewinnchance, die nur durch das Spielen an dieser Maschine ermittelt werden kann. Natürlich möchte der Spieler die Zahl an Münzen, die er in die Automaten mit den niedrigen Erfolgsquoten steckt, so gering wie möglich halten – also möglichst schnell herausfinden, ob er vor dem „richtigen“ Automaten sitzt.

Bayesian Bandit Algorithmus

Da es unzählige dynamische Entscheidungsregeln gibt, existiert auch eine Vielzahl an Bandit-Algorithmen. Ein bekanntes Beispiel ist der Bayesian Bandit Algorithm. Für jedes Banner-Design gibt es zum einen die Anzahl an Einblendungen und zum anderen die Anzahl an erfolgreichen Reaktionen. In der Annahme, dass die Reaktionen auf die einzelnen Einblendungen unabhängig voneinander sind und eine gleichbleibende Erfolgsquote aufweisen, kann aus den beiden Parametern die Wahrscheinlichkeitsverteilung der Erfolgsquote ermittelt werden.

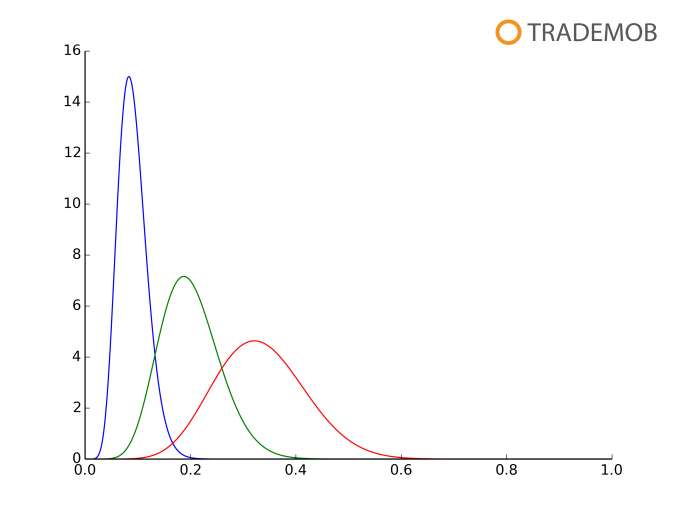

Hierbei handelt es sich um die Beta-Verteilung. Sobald die Verteilung für jedes Banner ermittelt ist, werden Stichproben gemäß der Verteilungen gezogen. Im nächsten Schritt wird das Design mit dem höchsten gezogenen Wert ausgewählt. Da die Varianz der Beta-Verteilung mit einer größer werdenden Anzahl an Einblendungen kleiner wird, während der Erwartungswert gegen den empirischen Mittelwert konvergiert, gibt es einen fließenden Übergang vom reinen Ausprobieren hin zum gezielten Einblenden des besten Banners.

Die Grafik zeigt verschiedene Beta-Verteilungen. Rot: 30 Versuche, 10 Erfolge. Grün: 50 Versuche, 10 Erfolge. Blau: 110 Versuche, 10 Erfolge. Mit steigender Anzahl an Versuchen sinkt die Varianz und der Erwartungswert konvergiert gegen den empirischen Mittelwert.

Bayes’sches Regressionsmodell

Die Herausforderung, das optimale Design auszuwählen, wird größer, wenn der Banner mehrere Dimensionen aufweist – beispielsweise Größe, Farbe und die Position auf dem Bildschirm –, die alle in die Berechnung miteinbezogen werden. Unter der Annahme, dass die verschiedenen Faktoren unabhängig voneinander sind, kann ein sogenanntes Bayes’sches Regressionsmodell eingesetzt werden, um auch hier die „Bandit“-Idee anzuwenden.

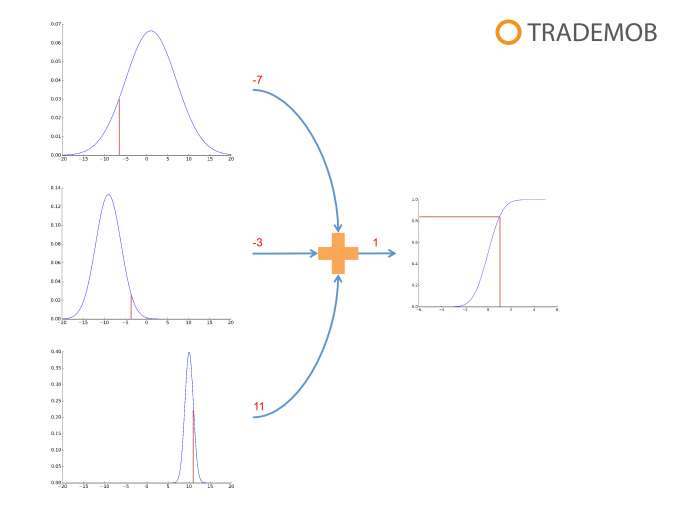

Die Anzahl an Einblendungen und die Anzahl an positiven Reaktionen für jeden Wert in jeder Dimension bilden nun die Grundlage dafür, die Parameter von Normalverteilungen zu ermitteln. Wie zuvor werden gemäß dieser Verteilungen Stichproben gezogen. Diese werden summiert und mittels einer Sigmoidfunktion auf einen Wert im Intervall zwischen 0 und 1 abgebildet, um eine Erfolgswahrscheinlichkeit für jedes einzelne Banner-Design zu bestimmen. Das Design mit der höchsten Wahrscheinlichkeit ist wiederum die beste Wahl für die nächste Einblendung.

Die Grafik zeigt den multidimensionalen Ansatz. Jeder Wert innerhalb einer Dimension wird mit einer Gauß’schen Verteilungskurve modelliert. Gemäß dieser Verteilungen wird für jede Dimension jeweils eine Stichprobe gezogen. Die gezogenen Werte werden summiert und mittels einer Sigmoidfunktion auf eine Zahl im Intervall zwischen 0 und 1 abgebildet.

Wer auf der Suche nach dem effektivsten Banner-Design seine Entscheidung bisher auf Basis von A/B-Tests getroffen hat, sollte dieses Vorgehen überdenken. Bandit-Algorithmen führen auf schnellerem und günstigerem Weg zu einer erfolgreichen Mobile-Advertising-Kampagne.

Über den Autor: Dr. Alexander Weiß ist Head of Data Analytics bei Trademob, eine der führenden internationalen Plattformen für Programmatic Mobile App Advertising. Um datenbasiert die beste Entscheidung zur Aussteuerung von App-Advertising-Kampagnen zu treffen, nimmt sein Team SSP-Traffic-Ströme unter die Lupe, clustert mobile Nutzer nach soziodemografischen Merkmalen und optimiert den automatisierten Bidding-Prozess zur Verbesserung der KPIs.

Beitragsbild: Shutterstock

Thanks for article! May be i wiil use it in my digital design agency.